Você já se perguntou como os grandes modelos de inteligência artificial, como o ChatGPT, são avaliados? Como sabemos qual deles é “melhor” em gerar textos, responder perguntas ou criar histórias? A resposta está em plataformas como o LMArena.

Longe de ser um laboratório secreto, o LMArena (anteriormente conhecido como Chatbot Arena) é uma plataforma pública e colaborativa onde qualquer pessoa pode participar do processo de avaliação dos Modelos de Linguagem Grande (LLMs). Imagine um “campo de batalha” digital onde diferentes IAs competem, e você, o usuário, é o juiz!

Para Que Serve o LMArena?

O principal objetivo do LMArena é fornecer uma maneira transparente e imparcial de comparar o desempenho de diversos LLMs. Enquanto testes de laboratório são importantes, a avaliação humana, feita por usuários reais em cenários práticos, oferece uma perspectiva valiosa sobre como esses modelos se comportam no “mundo real”.

Basicamente, ele serve para:

- Avaliar e Classificar LLMs: Através de um sistema de “batalhas” anônimas, o LMArena classifica os modelos de acordo com a preferência dos usuários. Isso gera um ranking (leaderboard) que mostra quais IAs estão se destacando.

- Melhorar a Qualidade dos Modelos: Os desenvolvedores das IAs podem usar o feedback e os resultados do LMArena para identificar pontos fortes e fracos em seus modelos, direcionando melhorias e treinamentos futuros.

- Educar o Público: A plataforma permite que qualquer pessoa experimente e compare diferentes IAs, desmistificando a tecnologia e mostrando o que esses modelos são capazes de fazer.

- Promover a Transparência: Ao tornar o processo de avaliação mais aberto, o LMArena contribui para uma maior confiança e compreensão sobre o desenvolvimento da inteligência artificial.

Como Usar o LMArena e Participar das Batalhas?

Usar o LMArena é surpreendentemente simples e divertido. Você não precisa ser um expert em IA para participar!

- Acesse a Plataforma: Vá para o site oficial do LMArena: lmarena.ai.

- Comece uma Batalha: Na página inicial, você verá uma interface onde pode começar a interagir. O sistema irá aleatoriamente selecionar dois LLMs diferentes, mas você não saberá quais são eles (eles serão identificados apenas como “Modelo A” e “Modelo B”).

- Faça sua Pergunta (Prompt): Digite uma pergunta, um pedido de texto, um problema de matemática, ou qualquer coisa que você queira que as IAs respondam. Por exemplo:

- “Me escreva um poema sobre um robô que aprende a amar.”

- “Explique a teoria da relatividade de forma simples.”

- “Me dê ideias para um presente de aniversário para uma criança de 5 anos.”

- Compare as Respostas: Ambos os modelos (A e B) gerarão suas respostas para o seu prompt. Leia atentamente as duas.

- Vote na Melhor Resposta: Depois de comparar, você deve escolher qual resposta foi melhor. As opções de voto geralmente incluem:

- “Modelo A é melhor”

- “Modelo B é melhor”

- “Empate”

- “Ambos ruins”

- Revele os Modelos (Opcional): Após votar, você terá a opção de “Revelar” para ver quais foram os modelos A e B que você acabou de avaliar. É sempre interessante descobrir quais IAs você gostou mais!

- Continue a Batalha: Você pode continuar fazendo novas perguntas e avaliando mais modelos, contribuindo cada vez mais para o ranking geral.

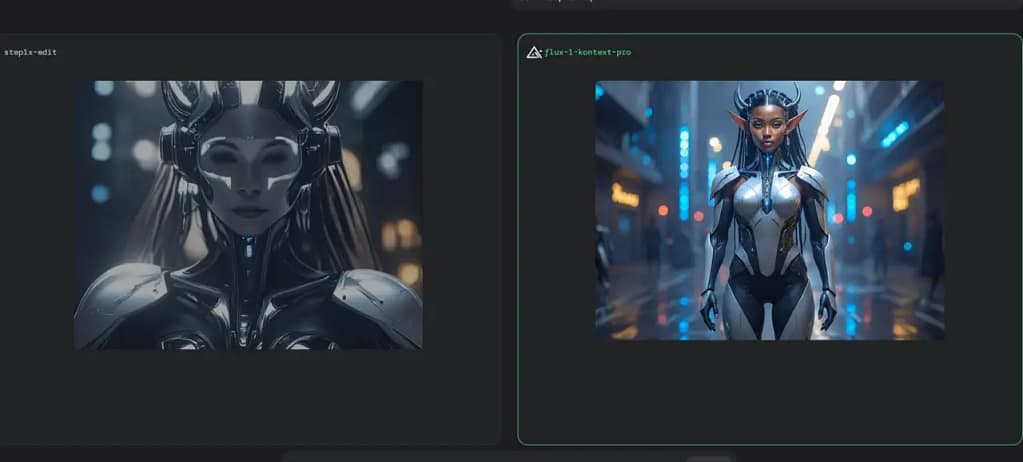

Testei muitas vezes e posso dizer que é uma ferramenta muito interessante; é bom lembra que no LMArena não terão TODAS as IAs; porém terão todas as mais relevantes do mercado, abaixo um exemplo que usei para duas IAs a Step1X-Edit (IAs de código aberto em fase inicial) vs Flux 1.0. Eu dei um prompt pedindo o restante do corpo da personagem e coloquei a imagem apenas do rosto com referencia e esse foi o resultado: